Исследователи создали огромный датасет для обучения ИИ, используя только открытые источники. Проект под названием Common Pile v0.1 объединяет 8 ТБ данных — от научных статей до чатов и патентов. В отличие от многих других наборов данных, для которых информация собиралась из интернета без четкого контроля лицензий, этот проект строго соблюдает правила открытого доступа.

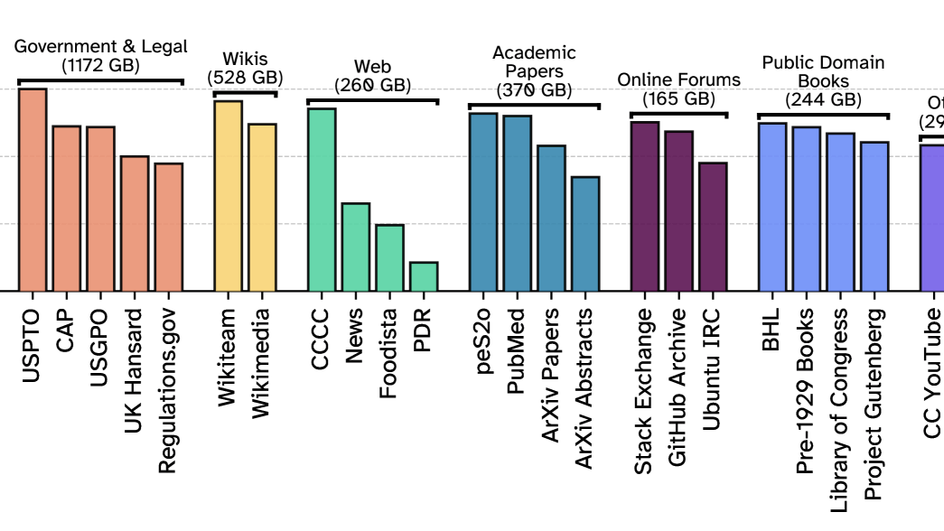

В датасет вошли материалы из Arxiv, PubMed, Project Gutenberg, GitHub, StackExchange и даже стенограммы заседаний британского парламента. Также добавлены юридические документы: патенты США, судебные решения и правительственные архивы. Отдельная часть данных — это образовательные ресурсы и текстовые расшифровки видео с 2 000 каналов на YouTube.

Главное требование, которое предъявляли авторы Common Pile v0.1, к контенту — наличие открытой лицензии (CC BY, CC BY-SA, CC0, MIT, BSD). Материалы с ограничениями (например, «только для некоммерческого использования») исключались из датасета. Кроме того, разработчики избегали сомнительных источников, таких как AI-сгенерированные тексты или данные с неясными условиями использования.

Перед тем, как данные попали в финальную версию датасета, их тщательно очистили: удалили дубликаты, рекламу, личную информацию и токсичный контент. Также отфильтровали неанглоязычные тексты и низкокачественные записи.

Несмотря на строгий отбор, авторы признают: идеального датасета все еще не существует. Даже в случае Common Pile все еще возможны ошибки в лицензировании или случайное включение неподходящего контента. Но новый датасет — важный шаг к более прозрачному и легальному обучению ИИ.

Олег Рогов, руководитель научной группы «Доверенные и безопасные интеллектуальные системы» Института AIRI, прокомментировал исследование специально для Науки Mail.

Решение полностью соответствует философии EleutherAI, сообщества разработчиков, стоящего за открытыми проектами как The Pile (датасет для обучения) и серии моделей GPT-Neo/GPT-J. Однако если The Pile включал данные с более свободной лицензией, но спорным происхождением (например, скрейпинг GitHub), то Common Pile уже делает ставку на максимальную юридическую чистоту данных.

Российский эксперт также отметил, что в релизе Common Pile v0.1, на его взгляд, сделан «мощный шаг к этически обоснованному обучению языковых моделей».

Этот 8-терабайтный корпус основан, по заявлению разработчиков, исключительно на лицензированном и общедоступном тексте от публичных книг до научных статей и патентов. Это позволяет избежать юридических рисков, связанных с несанкционированным скрейпингом лицензируемого контента. При этом обученные на нем модели Comma v0.1-1T и 2T с 7 млрд параметров демонстрируют производительность, сравнимую с аналогичными по размеру моделями, обученными на нелицензированных данных: от Llama 1 до Llama 2. Значимость заключается не только в достижении перспективной парадигмы «ответственных ИИ», но и в доказательстве того, что доступная, прозрачно составленная и юридически безопасная информация способна дать сравнимые результаты.

Тем не менее такой подход требует и серьезных ресурсов, тщательной ручной верификации, аннотирования и фильтрации данных. Поэтому могут быть ограничения в масштабируемости на уровне крупных корпораций, считает исследователь Института AIRI. Однако в будущем полноценная «этичная» инфраструктура данных может стать нормой, особенно по мере роста доступности открытых ресурсов, как это уже происходит в инициативах EleutherAI и LAION.

Ранее Наука Mail рассказывала о том, что нейросети научат вычислять научные фейки и детектировать сарказм.