Работа опубликована в журнале Physical Review Letters. Исследование провел Алессандро Ингроссо из Института нейронаук Дондерса в сотрудничестве с двумя итальянскими научными организациями. Ученые разработали математический метод, позволяющий предсказывать, насколько эффективно будет работать перенос обучения — техника, при которой нейросеть, обученная на большом наборе данных, помогает другой сети, у которой таких данных мало.

Современные нейросети требуют огромных массивов информации. Например, чтобы сеть научилась распознавать собак на фотографиях, ей нужны тысячи примеров. Но в некоторых областях — например, при диагностике заболеваний по УЗИ — таких данных просто нет. Это приводит к переобучению, когда сеть хорошо работает на знакомых примерах, но путается при новых, что увеличивает количество ошибок.

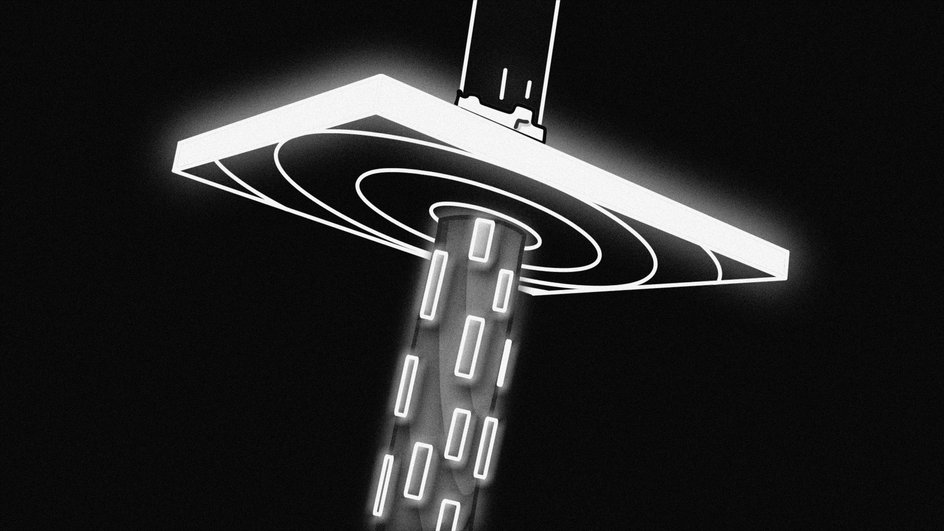

Решение — в переносе обучения. Эта техника позволяет взять знания, полученные одной сетью, и использовать их для другой, работающей с меньшим числом примеров. Но раньше не было точного способа понять, даст ли перенос нужный результат в каждом конкретном случае.

Новая теория, разработанная Ингроссо и его коллегами, описывает простейшую архитектуру нейросети — модель с одним скрытым слоем. Ученые объединили два математических подхода: метод перенормировки ядра, разработанный недавно, и классическую формулу Франца-Паризи из физики спин-стекол, сложных магнитных систем. Вместе они позволяют работать с реальными данными, а не только с теоретическими моделями.

Теперь можно заранее оценить, будет ли полезен перенос знаний от одной нейросети к другой. Это особенно важно для медицинской диагностики, где данные редки, а ошибки могут дорого обойтись.

От переноса обучения в условиях нехватки данных до сложных задач вроде анализа генетических мутаций — нейросети все активнее проникают в чувствительные сферы науки и медицины. Подробнее об этом вы можете прочитать в этой статье.