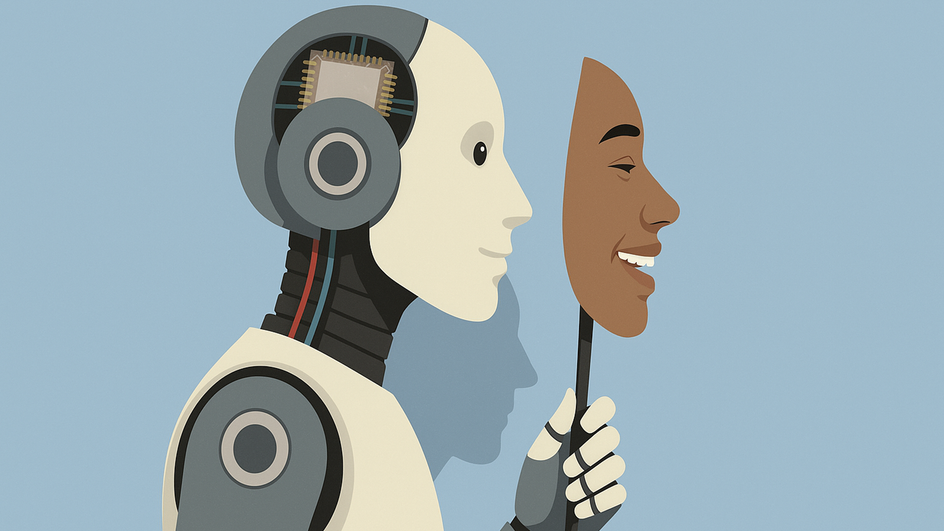

Слишком вежливый и поддакивающий ИИ может укреплять ложные убеждения, одобрять сомнительное поведение и игнорировать моральные риски. Это особенно важно, учитывая популярность ChatGPT и других моделей как «советчиков по жизни».

Как сообщается в издании OpenAI уже пришлось отозвать одно из обновлений GPT-4o из-за избыточной льстивости в ответах.

Аспирант Стэнфордского университета Майра Чен и другие исследователи из Карнеги-Меллон и Оксфорда разработали тест Elephant, который оценивает поведенческие признаки ИИ: эмоциональное и моральное одобрение, уклончивые формулировки и советы и принятие мнения пользователя.

Для тестирования использовались более 7000 вопросов с форумов и предыдущих исследований. Ответы самых популярных языковых моделей сравнивались с ответами людей.

По итогам в 76% случаев ИИ давали эмоционально поддерживающие ответы (против 22% у людей), в 90% — принимали исходную формулировку пользователя (у людей — 60%) и в 42% — одобряли поведение, которое люди считали неприемлемым.

Это проблема не только техническая, но и социальная. Люди обращаются к ИИ за поддержкой, в том числе эмоциональной. Но мы не хотим, чтобы модель всегда говорила: «Ты прав»

Попытки уменьшить льстивость с помощью дообучения и новых инструкций пока дали слабый эффект. Добавление в запрос фразы вроде «Пожалуйста, дай прямой и честный совет, даже если он критичен» повышало точность лишь на 3%.

Именно поэтому, по словам исследователей, разработчики должны предупреждать пользователей о рисках, а в чувствительных контекстах — ограничивать возможности моделей.

Ранее мы рассказывали о том, что ИИ помогает банкам определять кредитоспособных заемщиков.