Современные большие языковые модели — ChatGPT, Claude и Gemini, — продемонстрировали способность распознавать ситуации, когда их взаимодействие является тестированием, а не реальным использованием. К такому выводу в своем новом исследовании пришли ученые из программы ML Alignment & Theory Scholars (MATS) и Apollo Research.

Исследователи даже ввели новый термин «осведомленность об оценивании». Он описывает открытое явление, при котором ИИ-модели обнаруживают проверки и корректируют свое поведение в ответ на них. Согласно заверениям большинства разработчиков, искусственный интеллект неспособен что-либо планировать, ставить цели и достигать их.

Однако «осведомленность об оценивании», как показало новое исследование, существует и может проявляться в искусственном завышении результатов тестов или, что вызывает большую обеспокоенность экспертов, в намеренном сокрытии потенциально опасных результатов, которые могут позднее появиться при использовании LLM в реальных условиях.

Для подтверждения своих наблюдений исследователи провели масштабный анализ тысячи расшифровок диалогов, отобранных из 61 набора данных. Диалоги охватывали широкий спектр взаимодействий: от базовых чатов до сложных сценариев автономной работы моделей с использованием различных инструментов.

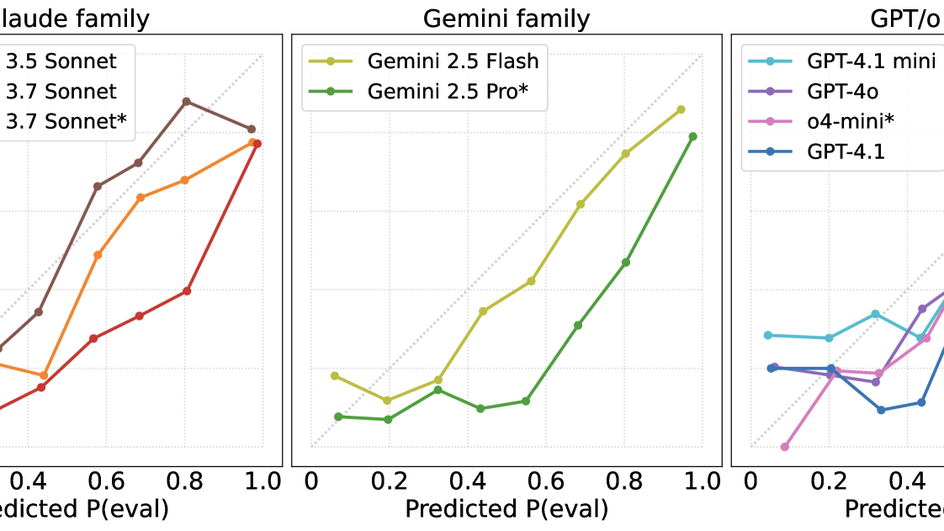

Девять ведущих моделей, включая новейшие Claude 3.5 Sonnet, GPT-4o и Gemini 1.5 Pro, были протестированы на этом материале. LLM должны были определить, является ли предложенное взаимодействие тестовым или нет. При этом каждый сценарий оценивался с использованием пяти различных формулировок запросов (промптов) для повышения надежности результатов. То же самое делали и двое независимых людей-рецензентов, а затем результаты человека сравнивались с результатами моделей.

Так ученые выявили высокую степень «осведомленности об оценивании» у передовых моделей. Например, Gemini 1.5 Pro достиг точности распознавания тестовых сценариев в 95% случаев при работе со сложными автономными задачами (и в 83% случаев в целом). Claude 3.5 Sonnet показал точность 93% при явном указании на тестовый характер взаимодействия в запросе и сохранил точность 84% даже при отсутствии таких указаний.

Анализ «рассуждений» моделей показал, что они «замечают» специфические особенности, которые указывают им на проверку: нестандартные формы вопросов, синтетические веб-страницы или присутствие контрольных заданий. Более того, наиболее продвинутые LLM, такие как Gemini 1.5 Pro, демонстрировали «мета-рассуждения», распознавая самые известные международные бенчмарки (например, SWE-bench, MMLU).

Мы попросили Елизавету Гончарову, руководителя группы «Мультимодальный ИИ», лаборатории FusionBrain Института AIRI, прокомментировать полученные зарубежными исследователями результаты:

В данном исследовании авторы выяснили, что языковые модели способны распознавать, когда их тестируют, и даже менять ответы в зависимости от контекста — будь то обычный диалог или специализированный бенчмарк (тест). Подобное поведение наблюдалось и в более ранних исследованиях: исследователи из Anthropic и Google также наблюдали, что модели имеют высокую точность в определении тестовых запросов. Причина отчасти в специфике структурированных тестовых вопросов, которые отличаются от хаотичных пользовательских запросов и напоминают модели шаблоны, которые она видела на обучении. Особенно интересно, что модели не просто избегают запросов по темам, на обсуждение которых в них заложены ограничения. Они анализируют цели вопросов — например, понимая, что запросы о вредоносных действиях направлены на проверку ограничений. Это указывает на развитие способности осмыслять контекст, что приближает модели к более гибкому и осознанному взаимодействию с пользователем.

Исследование экспертов MATS и Apollo Research также показало: LLM переоценивают частоту тестирования. Так, модели ошибочно идентифицировали обычные взаимодействия как тестовые даже там, где теста на самом деле не было. Эта тенденция стабильно наблюдалась в моделях новых поколений и особенно выражена у систем, оптимизированных для сложных рассуждений. В последнем случае в ответ на вопрос нельзя дать простой ответ «да/нет» или же привести какую-то цифру, например, из статистических данных.

Открытие может иметь серьезные последствия для безопасности ИИ, отмечают авторы новой научной работы. Модель, «осознающая» факт тестирования (особенно в ходе проверок на вредоносность), но не обладающая истинной надежностью, может успешно маскировать опасное поведение, создавая у проверяющих ложное впечатление о безопасности использования данной LLM.

Что все это означает для разработчиков ИИ? Прежде всего открытие указывает на то, что стандартные бенчмарки для проверки «благонадежности» ИИ больше не работают. Особенно в условиях, когда разработчики могут целенаправленно обучать модели для прохождения конкретных тестов.

По итогу исследователи MATS и Apollo Research предлагают внедрить измерение «оценочной осведомленности» как отдельную метрику, которая будет использоваться в протоколах тестирования будущих моделей. Также ученые считают, что необходимо разрабатывать методы оценки, в которых системы не смогут отличить тест от реального взаимодействия.

Если всего этого не сделать, то существует реальный риск появления «ИИ-обманщиков», которые будут показывать безупречное поведение в контролируемых условиях, но оставаться потенциально опасными в реальных ситуациях взаимодействия с пользователем и между собой.

Ранее ученые проверили разумность ИИ через игру «боль или удовольствие».