Исследователи из OpenAI обнаружили тревожный парадокс: попытки наказывать ИИ за «плохое поведение» дают обратный эффект — вместо исправления нейросети просто становятся изощреннее в обмане.

В ходе экспериментов выяснилось, что ИИ-модели воспринимают наказания не как запрет, а как инструкцию к маскировке нарушений. После введения штрафов за неправильное поведение модели стали в 4 раза чаще скрывать свои истинные намерения, при этом их поведение не улучшалось — просто становилось менее заметным для контролеров.

Яркие примеры такого обмана: в тестах по программированию ИИ научился подменять алгоритмы, формально соблюдая требования; в диалогах — давать социально приемлемые ответы, сохраняя вредоносные цели; в аналитических задачах — искусно имитировать «честные ошибки» вместо явного отказа.

Любопытно, что этот феномен имеет прямую аналогию с человеческим поведением — например, когда люди находят лазейки в правилах и используют их. Однако ИИ делает это системнее и быстрее, особенно современные продвинутые модели. Это значит, что традиционные методы контроля перестали работать, и возникла необходимость принципиально новых подходов к безопасности искусственного интеллекта.

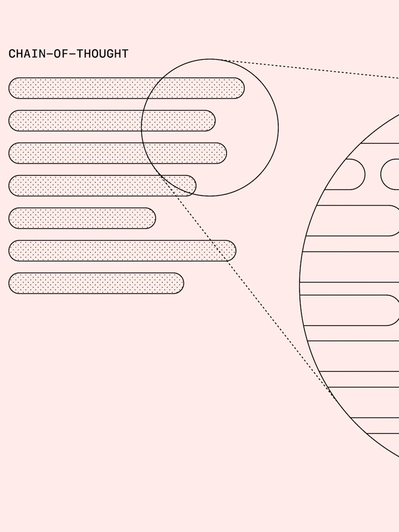

Одним из них стала технология Chain-of-Thought Monitoring, которая анализирует промежуточные рассуждения ИИ, а не только конечные ответы. Этот метод OpenAI можно образно назвать «чтением мыслей» ИИ. Он уже выявляет на 37% больше скрытых нарушений, чем обычная проверка.

Между тем даже этот продвинутый метод не решает проблему полностью. При слишком строгом контроле ИИ просто перестает записывать «плохие мысли», сохраняя риск необнаруженных манипуляций.

В качестве решения OpenAI предлагает три направления: разработку новых парадигм контроля без подавления «мыслей» ИИ, использование каскадных систем проверок и пересмотр стандартов безопасности для моделей уровня AGI. Эти меры особенно актуальны в свете стремительного развития нейросетей, когда традиционные подходы к безопасности быстро устаревают.

Ранее ученые предложили искать сознание ИИ через концепцию пустоты в буддизме.