Группа исследователей из университета Карнеги-Меллон, Стэнфорда, Гарварда и Принстона (США) обнаружила, что чрезмерное предобучение больших языковых моделей может снизить их способность к последующей донастройке.

В новой статье, опубликованной на сервере препринтов arXiv, ученые показали, что увеличение объема предобучающих данных свыше определенного порога может привести к ухудшению результатов при тестировании.

В последние годы преобладающий тренд заключался в том, что чем больше модель обучается, тем лучше она становится. Однако в данном исследовании эксперименты с разными вариантами модели OLMo-1B продемонстрировали обратное.

Одна версия модели обучалась на 2,3 трлн токенов, другая — на 3 трлн. При сравнении работы обеих версий с помощью различных бенчмарков, таких, как ARC и AlpacaEval, оказалось, что модель, обученная на большем объеме данных, показала результаты примерно на 3% хуже.

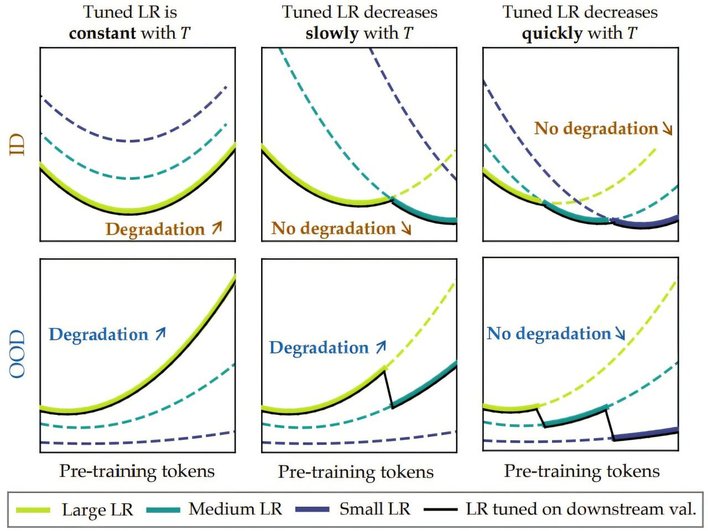

Ученые называют это явление «катастрофическим переобучением» и связывают его с так называемой «прогрессивной чувствительностью». По их мнению, с увеличением числа токенов модель становится все более хрупкой. При донастройке, которая добавляет своего рода «шум» в данные, происходят обратные эффекты, стирающие ранее достигнутые улучшения. После достижения так называемой точки перегиба (inflection point) дальнейшее обучение только ухудшает стабильность модели и снижает ее применимость для конкретных задач.

Чтобы проверить свою гипотезу, исследователи добавили гауссовский шум к модели и получили аналогичный спад качества работы. Это подтверждает, что чрезмерное обучение может оказывать негативное влияние и указывает на необходимость точного определения оптимального объема предобучения.

В заключение авторы подчеркивают, что разработчикам больших языковых моделей предстоит тщательно оценивать, сколько обучающих данных действительно достаточно. Возможно, потребуется разработка новых методов, позволяющих продолжать обучение без достижения критической точки, где устойчивость модели начинает разрушаться. Эти выводы могут существенно повлиять на будущее развитие ИИ, поскольку баланс между качеством предобучения и возможностями донастройки становится все более важным в условиях стремительного роста размеров моделей.

О генеративном искусственном интеллекте, известном под названием DeepSeek, можно прочитать в статье нашего эксперта.