Эмоции — сложный феномен, выражающий уникальный субъективный опыт и переживания. Сегодня ИИ учится их расшифровывать: алгоритмы анализируют мимику, распознавая эмоции на лице, а также интерпретируют настроение голоса и текста. Однако даже самые продвинутые системы остаются «эмоционально невосприимчивыми»: они фиксируют эмоциональные паттерны в речи собеседника и дают соответствующий ответ, но у них отсутствует понимание сути эмоций.

Лимбический резонанс — та самая «магия» живого общения, когда собеседники чувствуют и переживают настроение друг друга — недоступен машинам. И хотя ИИ-собеседники уже способны поддерживать нас словом, ключевой вопрос остается открытым: где грань между полезным инструментом и опасной иллюзией «живого» общения с роботом?

Моделирование эмоций: что уже умеют роботы?

Эмоции составляют неотъемлемую часть человеческой природы. Они служат основой для принятия решений, определяют наши поступки и формируют взаимодействие с окружающим миром, другими людьми и даже самим собой. Примечательно, что одно и то же событие или внешний стимул способны вызывать совершенно непохожие по содержанию и продолжительности эмоциональные реакции у разных людей. Этот комплекс переживаний становится уникальным отражением личности. Его можно назвать удивительным и многогранным феноменом, который мы воспринимаем как нечто само собой разумеющееся, не всегда осознавая всю его глубину. Еще более удивительно то, что современная наука не только изучает и систематизирует эмоции, но и стремится к их воссозданию вплоть до моделирования и передачи роботизированным системам.

Одним из наиболее ярких примеров попытки воссоздания «эмоционально чувствующего» искусственного существа стал робот София, разработанный гонконгской компанией Hanson Robotics. Этот человекоподобный андроид оснащен искусственным интеллектом, способен обрабатывать данные, полученные вербально и невербально, то есть распознавать человеческие лица и эмоции. Но наиболее примечательная его особенность — умение генерировать ответы, сопровождаемые мимикой, что создает иллюзию проявления эмоций.

Активированная в 2015 году, София быстро стала медийным феноменом: она участвовала во многочисленных интервью, публичных мероприятиях и даже получила гражданство Саудовской Аравии — беспрецедентный случай для искусственного интеллекта. Однако признать Софию эмоционально чувствующим существом было бы серьезным преувеличением. На официальном сайте разработчиков приводится ее самопрезентация, где утверждается, что робот обладает «собственными эмоциями», которые как бы имитируют работу человеческого мозга. Там же упоминается о «коллективном разуме» внутри систем Софии — команде специалистов по ИИ, философов, художников и других экспертов, работающих над очеловечиванием этого робота. То есть те эмоции, которые показывает София — результат работы целого коллектива ученых, программирующих ее реакции.

Этот пример демонстрирует, насколько далеко продвинулась наука в вопросе передачи эмоциональных реакций искусственным системам. Однако ключевой вопрос остается открытым: способен ли искусственный интеллект на подлинное эмоциональное переживание, или мы наблюдаем лишь сложную симуляцию, основанную на алгоритмических процессах?

Как работают «эмоциональные» ИИ?

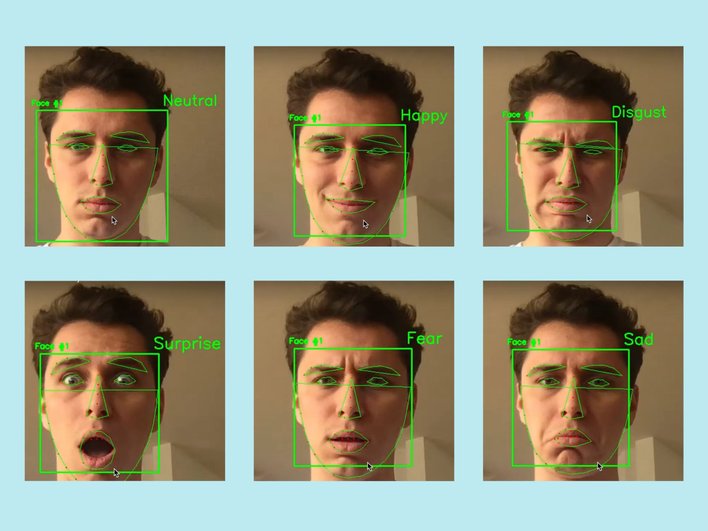

Создание алгоритмов распознавания эмоций через анализ мимики основано на тех же принципах, что и человеческое восприятие. Если не учитывать случаи намеренного сокрытия эмоций, базовые состояния — гнев, радость, удивление

Алгоритмы работают схожим образом. Сначала модель обучается на размеченных данных — тысячах фотографий лиц с указанными на них эмоциями. Она выделяет ключевые точки лица, анализирует их смещение относительно нейтрального состояния и выявляет закономерности. После обучения система уже может сопоставлять новые изображения с определенными паттернами и «считывать» эмоции.

Примерно то же самое с распознаванием эмоций голоса. Но ситуация здесь сложнее, ведь тональность и вариативность речи гораздо богаче. С другой стороны, вариантов создания алгоритмов здесь больше. Можно отслеживать амплитуду, частотные и временные параметры, искать ключевые слова и выражения или представлять звук в виде спектрограммы и работать с ним как с двумерным изображением.

Наибольшие сложности возникают при анализе текстовых сообщений. Даже в человеческом общении в цифровом формате эмоциональность часто теряется. Мы компенсируем это с помощью эмодзи, пунктуации, намеренных орфографических искажений или изменения регистра букв. Однако даже эти меры не всегда обеспечивают точное понимание настроения собеседника.

Несмотря на исключительную сложность задачи, современные алгоритмы демонстрируют определенные успехи в анализе эмоций в тексте. Как и в предыдущих случаях, они работают по принципу обучения на размеченных данных — огромных массивах текстов, где каждому высказыванию соответствует эмоциональная метка. Модели выявляют сложные закономерности: от очевидных лексических повторений до тонких синтаксических особенностей и контекстуальных связей.

Современные генеративные модели, такие как GPT (Generative Pre-trained Transformer), демонстрируют впечатляющие способности в эмпатическом взаимодействии — они научились не только распознавать, но и адекватно реагировать на проявление эмоций в тексте. Это достижение особенно значимо, учитывая принципиальную сложность такой задачи.

Ярким примером интеграции вышеобозначенных технологий стал человекоподобный робот Амека, разработанный британской компанией Engineered Arts в 2021 году. Оснащенный системой компьютерного зрения, системами анализа аудио и подключенный к GPT-3/GPT-4, он демонстрирует качественно новый уровень взаимодействия. В отличие от Софии, чьи реакции преимущественно запрограммированы, Амека способен адаптироваться к ситуации в реальном времени, проявляя гибкость в принятии решений.

Однако фундаментальное ограничение сохраняется: все эти системы работают в рамках заложенных заранее алгоритмических паттернов. Их «эмоциональные» реакции — это сложная, но все же комбинация ранее обработанных данных, а не подлинное субъективное переживание. Мы наблюдаем точную трансляцию смоделированных эмоциональных шаблонов, но не эмоцию как внутренний психический процесс.

Симуляция vs. Настоящие чувства

Главный философский вопрос: действительно ли машина «понимает» эмоции или лишь их имитирует? Между механической обработкой данных и подлинным осознанием все же принципиальная разница. Одно дело принять данные, сопоставить их с внутренними алгоритмами и ретранслировать ответ, и совсем другое — внутренне переварить эти же данные.

Мысленный эксперимент американского философа Джона Серла с «китайской комнатой» наглядно демонстрирует эту проблему. Человек в комнате, не зная китайского, получает карточки с вопросами на этом языке. У него есть карточки с ответами и инструкциями. Он отвечает на вопросы по инструкциям, создавая лишь видимость понимания. Аналогично компьютер обрабатывает наши запросы, не погружаясь в смысл беседы. Серл утверждает: машины оперируют лишь синтаксисом (формальными правилами), тогда как человек работает с семантикой (смыслами). Формальные алгоритмы не могут породить сознание или подлинное понимание.

И хотя современные модели GPT успешно проходят тест Тьюринга, который анализирует их способность имитировать человеческое общение, это доказывает лишь мастерство их создателей, но не наличие подлинного человеческого разума. Но тогда возникает вопрос: так ли важно для нас, кто нам отвечает — человек или машина, если результат убедителен?

Нейробиология дает четкий ответ: разница принципиальна. В человеческом общении ключевую роль играет лимбический резонанс — особая синхронизация эмоциональных состояний собеседников через взаимодействие лимбических систем. Этот биологический механизм обеспечивает эмпатию, чувство безопасности и глубокую взаимосвязь с собеседником, недостижимую для искусственных систем.

Сознание остается исключительным свойством живой материи. Даже самые совершенные GPT работают лишь с информацией, тогда как человеческое сознание оперирует сложным единством информации и эмоциональных смыслов. Технологии могут имитировать проявления сознания, но неспособны породить подлинный опыт проявления эмоций.

Этические вопросы

Прогрессирующее усложнение ИИ порождает серьезные этические дилеммы. Если система достигнет уровня, сопоставимого с человеческим интеллектом, возникнет вопрос о правовом статусе: должны ли мы наделять ее правами, и если да, то какими? Параллельно встает проблема регулирования — какие механизмы контроля смогут предотвратить злоупотребления, например, манипуляцию уязвимыми группами через имитацию эмоциональной поддержки?

Особую сложность представляет вопрос ответственности. В отличие от человека, ИИ не обладает сознанием или субъективными намерениями, но его действия (особенно в эмоционально напряженных ситуациях) могут причинить реальный вред. Кто должен отвечать за последствия? Все это требует принципиально новых правовых рамок.

Будущее эмоционального ИИ

Стремительное развитие эмоционального ИИ открывает перспективу появления роботов-психологов и компаньонов для пожилых людей, способных оказывать базовую эмоциональную поддержку и психологическую помощь.

Такие ассистенты могут значительно улучшить качество жизни, обеспечивая круглосуточный мониторинг здоровья, напоминая о лекарствах, предлагая когнитивные тренировки и уменьшая уровень социальной изоляции через осмысленные диалоги. Их ключевое преимущество заключается в способности заполнять критические пробелы в уходе — от бытовой помощи до базовой эмоциональной поддержки. Хотя технология не лишена этических сложностей, ее разумное применение способно смягчить такие острые социальные проблемы, как одиночество пожилых и нехватка квалифицированного ухода.

Что ждет нас в эпоху «чувствующих» алгоритмов?

Эмоции, которые мы наблюдаем у роботов и ИИ-собеседников, остаются искусной имитацией, алгоритмическим инструментом, лишенным подлинного понимания и той субъективной глубины, что рождает лимбический резонанс между людьми. Однако если технологии достигнут уровня, когда «искусственные» эмоции станут неотличимы от человеческих, это потребует глобального пересмотра всех норм взаимодействия с такими системами. Придется заново определить границы между инструментальной помощью и искусственным сознанием, между обслуживающими функциями и видимостью эмоциональной близости. Это вызовет не только технологические, но и глубокие философско-правовые вопросы: где провести черту, если алгоритм научится убедительно воспроизводить то, что мы привыкли считать исключительно человеческим?