Большинство современных исследований в области компьютерного зрения связано с изучением человека и его окружающей среды, а некоторые разработки в итоге используются в технологиях слежки. К такому выводу пришли ученые по результатам исследования, опубликованного в журнале Nature.

Исследователи изучили 19 тыс. научных работ, которые были представлены на ведущей конференции по компьютерному зрению (CVPR) с 1990 по 2020 год, а также 23 тыс. патентов, ссылающихся на эти публикации. Согласно результатам, 90% научных статей и 86% соответствующих патентов связаны с визуализацией человека и его пространства. Лишь 1% работ был направлен на извлечение исключительно неантропоморфных данных. Авторы отметили, что доля исследований, ведущих к патентам с признаками технологий наблюдения, значительно выросла: с 53% в 1990-х до 78% в 2010-х годах.

Практически вся область работает над лицами и походкой, над распознаванием людей на изображениях, и никто, кажется, не задает себе вопрос: «Что мы вообще делаем?»

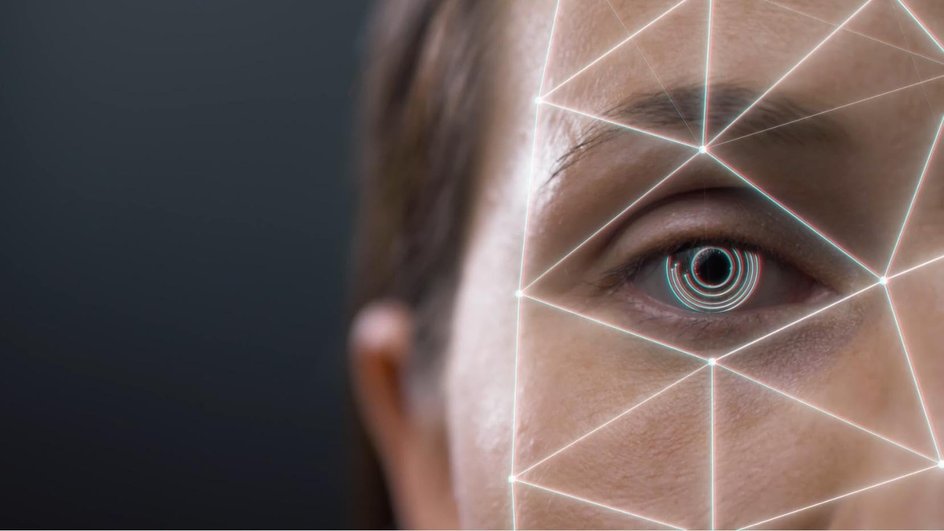

Развитие систем наблюдения ускорилось с ростом возможностей искусственного интеллекта. Такие технологии позволяют распознавать людей, фиксировать их поведение, идентифицировать по лицу или походке, а также отслеживать определенные действия.

Отдельное внимание исследователи уделили терминологии научных работ. По их данным, в статьях людей часто называют «объектами», а пространства — «сценами». Как уточнили ученые, такая формулировка может затруднять этическую оценку и способствовать недостаточному контролю при работе с персональными данными.

Ранее Наука Mail писала, что Google представил ИИ-модель для расшифровки генома.